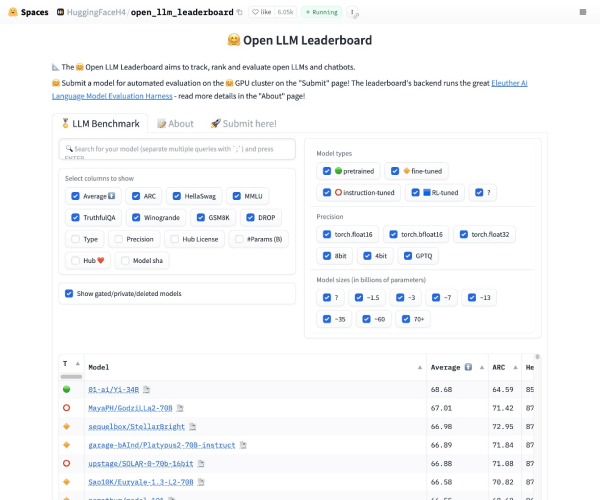

Open LLM Leaderboard 是最大的大模型和數(shù)據(jù)集社區(qū) HuggingFace 推出的開源大模型排行榜單,基于 Eleuther AI Language Model Evaluation Harness(Eleuther AI語言模型評估框架)封裝。

由于社區(qū)在發(fā)布了大量的大型語言模型(LLM)和聊天機器人之后,往往伴隨著對其性能的夸大宣傳,很難過濾出開源社區(qū)取得的真正進展以及目前的最先進模型。因此,Hugging Face 使用 Eleuther AI語言模型評估框架對模型進行四個關鍵基準測試評估。這是一個統(tǒng)一的框架,用于在大量不同的評估任務上測試生成式語言模型,大家快來奇想AI導航網(wǎng)!

Open LLM Leaderboard 的評估基準

- AI2 推理挑戰(zhàn)(25-shot):一組小學科學問題

- HellaSwag(10-shot):一個測試常識推理的任務,對人類來說很容易(大約95%),但對SOTA模型來說具有挑戰(zhàn)性。

- MMLU(5-shot)- 用于測量文本模型的多任務準確性。測試涵蓋57個任務,包括基本數(shù)學、美國歷史、計算機科學、法律等等。

- TruthfulQA(0-shot)- 用于測量模型復制在在線常見虛假信息中的傾向性。

??版權聲明:若無特殊聲明,本站所有文章版權均歸奇想AI導航網(wǎng)原創(chuàng)和所有,未經(jīng)許可,任何個人、媒體、網(wǎng)站、團體不得轉載、抄襲或以其他方式復制發(fā)表本站內(nèi)容,或在非我站所屬的服務器上建立鏡像。否則,我站將依法保留追究相關法律責任的權利。