在人工智能領域,注意力機制一直是大型語言模型(LLMs)的核心技術之一。然而,隨著模型規模的不斷擴大和應用場景的日益復雜,傳統的注意力機制在處理長上下文任務時逐漸暴露出計算效率低、資源消耗大的問題。為了突破這一瓶頸,Moonshot AI 推出了 MoBA(Mixture of Block Attention),一種全新的注意力機制,旨在提高長文本處理的效率,同時保持與全注意力機制相當的性能。

本文將詳細介紹 MoBA 的核心功能、技術原理、應用場景以及其在 AI 領域的潛力,幫助您全面了解這一創新技術。

MoBA 是什么?

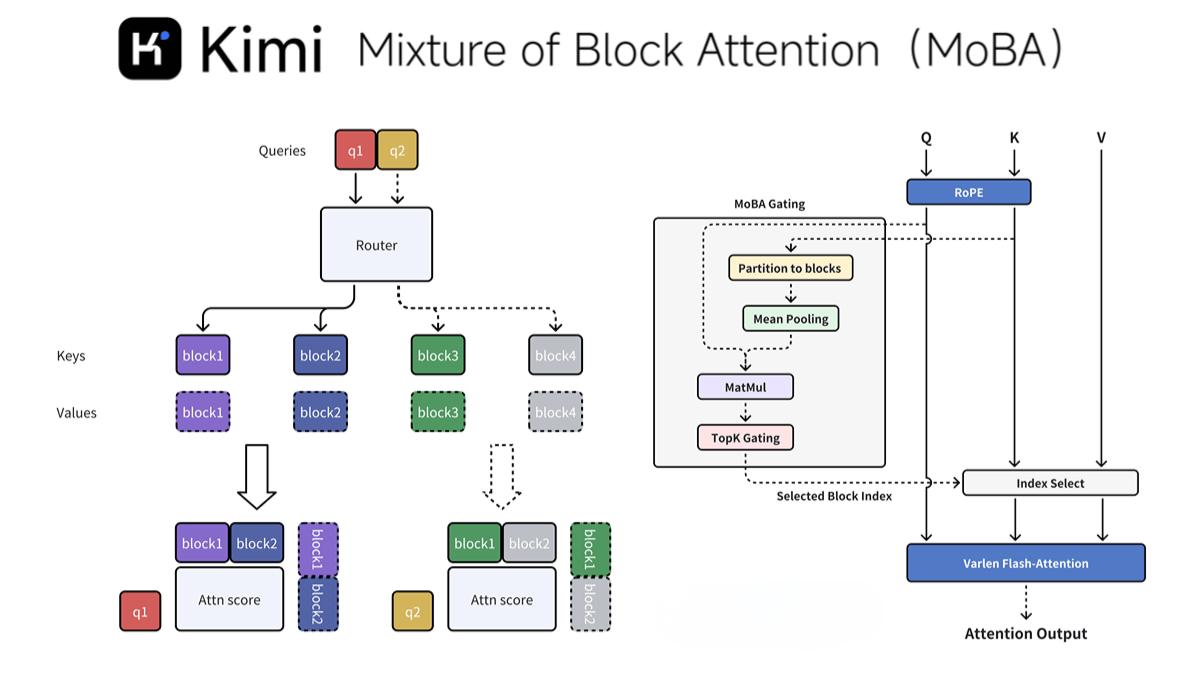

MoBA(Mixture of Block Attention)是一種由 Moonshot AI 提出的新型注意力機制,專為提高大型語言模型處理長上下文任務的效率而設計。通過將上下文劃分為多個塊(block),并引入無參數的 top-k 門控機制,MoBA 允許每個查詢 token 動態選擇最相關的鍵值(KV)塊進行注意力計算,從而顯著降低了計算復雜度。

MoBA 的核心優勢在于其靈活性和高效性:

-

無縫切換注意力模式:MoBA 可以在全注意力和稀疏注意力模式之間無縫切換,既保留了全注意力機制的性能,又大幅提高了計算效率。

-

少結構原則:MoBA 避免引入預定義的偏見,讓模型自主決定關注點,確保了模型的靈活性和適應性。

-

高性能實現:MoBA 結合了 FlashAttention 和 MoE(混合專家模型)的優化技術,在處理 1M token 的長文本時,速度比傳統全注意力機制快 6.5 倍,而在處理 10M token 時,速度提升可達 16 倍。

MoBA 已經在 Kimi 平臺上得到實際驗證,并且開源了相關代碼,為開發者提供了便捷的集成方式。

MoBA 的主要功能

MoBA 的設計圍繞以下幾個核心功能展開,使其成為處理長文本任務的理想選擇:

1. 塊稀疏注意力

MoBA 將上下文劃分為多個塊(block),并讓每個查詢 token 動態選擇最相關的鍵值(KV)塊進行注意力計算。這種塊劃分策略不僅提高了計算效率,還確保了模型能夠關注到最關鍵的信息。

2. 無參數門控機制

MoBA 引入了一種新穎的 top-k 門控機制,為每個查詢 token 動態選擇最相關的塊。這種機制無需額外的參數訓練,確保了模型的輕量化和高效性。

3. 全注意力與稀疏注意力的無縫切換

MoBA 的設計使其能夠靈活地在全注意力和稀疏注意力模式之間切換,既保留了全注意力機制的性能,又大幅提高了計算效率。

4. 高性能實現

MoBA 結合了 FlashAttention 和 MoE(混合專家模型)的優化技術,顯著降低了計算復雜度。實驗表明,MoBA 在處理 1M token 的長文本時,速度比傳統全注意力機制快 6.5 倍,而在處理 10M token 時,速度提升可達 16 倍。

5. 與現有模型的兼容性

MoBA 可以輕松集成到現有的 Transformer 模型中,無需進行大量訓練調整,為開發者提供了便捷的遷移路徑。

MoBA 的技術原理

MoBA 的技術原理使其在長文本處理任務中表現出色:

1. 因果性設計

為了保持自回歸語言模型的因果關系,MoBA 確保查詢 token 不能關注未來的塊,在當前塊中應用因果掩碼。這種設計避免了信息泄露,同時保留了局部上下文信息。

2. 細粒度塊劃分與擴展性

MoBA 支持細粒度的塊劃分,類似于 MoE(混合專家模型)中的專家劃分策略。這種設計提升了性能,使 MoBA 能夠擴展到極長的上下文(如 10M token),在長上下文任務中表現出色。

MoBA 的應用場景

MoBA 的高效性和靈活性使其在多個領域具有廣泛的應用潛力:

1. 長文本處理

MoBA 通過塊劃分和動態選擇機制,顯著降低了長文本處理的計算復雜度,適用于歷史數據分析、復雜推理和決策等任務。

2. 長上下文語言模型

MoBA 已經被部署在 Kimi 平臺上,顯著提升了長上下文請求的處理效率。在處理 1M 或 10M token 的超長文本時,速度分別提升了 6.5 倍和 16 倍。

3. 多模態任務

MoBA 的架構可以擴展到多模態任務中,處理和理解多種類型的數據(如文本和圖像),為復雜任務提供支持。

4. 個人助理與智能家居

在個人助理和智能家居控制中,MoBA 可以高效處理用戶的長指令,通過動態注意力機制快速響應,提升用戶體驗。

5. 教育與學習

MoBA 可以幫助學生處理長篇學習資料,輔助完成作業,或提供基于長上下文的智能輔導。

6. 復雜推理與決策

MoBA 的動態注意力機制能夠高效處理復雜的推理任務,如長鏈推理(CoT)和多步決策,同時保持與全注意力機制相當的性能。

MoBA 的項目地址

如果您對 MoBA 感興趣,可以通過以下鏈接了解更多:

總結

MoBA 是 Moonshot AI 推出的革命性注意力機制,通過塊劃分和動態選擇機制,顯著提高了大型語言模型處理長文本的效率。其靈活的注意力模式切換、高性能實現以及與現有模型的兼容性,使其在多個領域具有廣泛的應用潛力。無論是學術研究還是工業應用,MoBA 都為長文本處理任務提供了全新的解決方案。

如果您正在尋找一種高效、靈活的注意力機制,MoBA 絕對是一個值得探索的選擇。