在AI技術飛速發展的今天,視頻生成技術正在成為各個行業的焦點。無論是影視制作、廣告營銷,還是虛擬現實,高質量的視頻內容需求日益增長。然而,傳統的視頻生成技術往往受限于角色控制的靈活性和視頻質量的穩定性,難以滿足多樣化的需求。

AnyCharV的出現,為這一領域帶來了革命性的突破。由香港中文大學、清華大學深圳國際研究生院和香港大學聯合開發的AnyCharV,是一款角色可控的視頻生成框架。它通過創新的兩階段訓練策略,實現了高質量的角色視頻生成,同時支持復雜的人-物交互和背景融合。本文將詳細介紹AnyCharV的功能、技術原理及其應用場景,幫助讀者全面了解這一前沿AI工具。

AnyCharV的主要功能:靈活高效的角色視頻生成

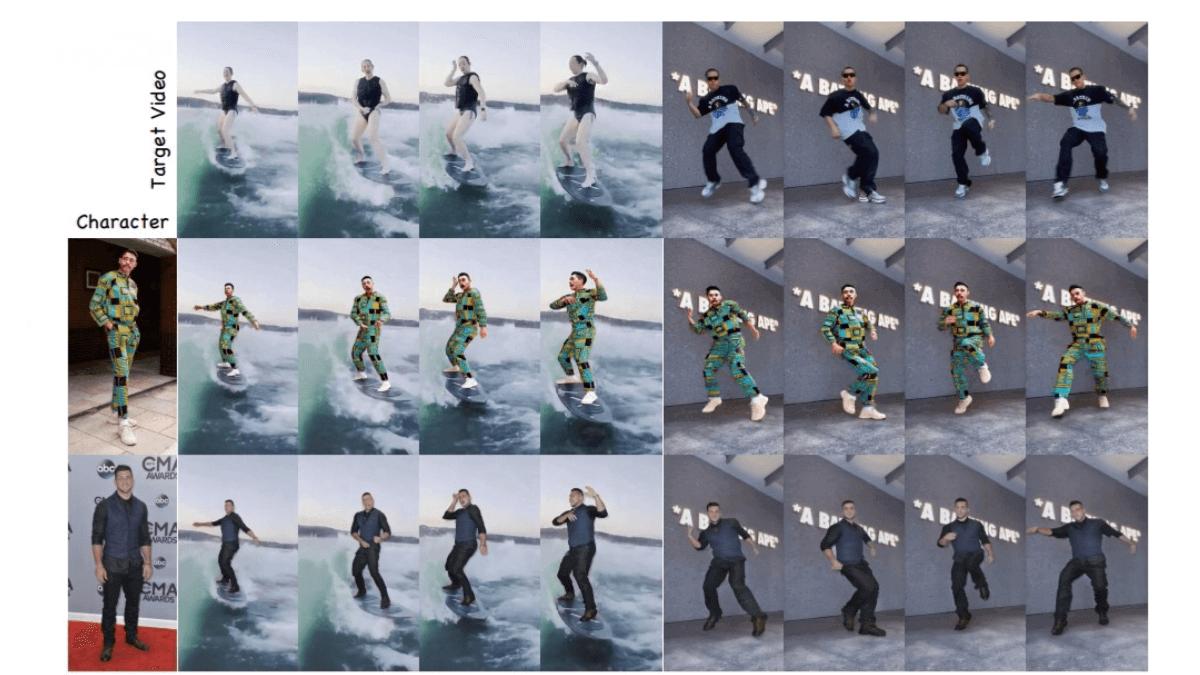

AnyCharV的核心功能在于其強大的角色可控能力。它能夠將任意給定的角色圖像與目標驅動視頻相結合,生成自然、高質量的視頻。以下是AnyCharV的主要功能亮點:

-

任意角色與目標場景的合成 AnyCharV支持將任意角色圖像與目標驅動視頻結合,生成自然流暢的視頻內容。無論是電影中的虛擬角色,還是廣告中的產品代言人,AnyCharV都能輕松實現角色與場景的無縫融合。

-

高保真角色細節保留 通過自增強訓練和粗粒度掩碼引導,AnyCharV能夠精確保留角色的外觀和細節,避免傳統視頻生成技術中常見的失真問題。這意味著生成的視頻不僅質量高,還能真實還原角色的特征。

-

復雜場景與人-物交互 AnyCharV支持角色在復雜背景下的自然交互,如運動、物體操作等。無論是影視特效中的動作場景,還是虛擬現實中的互動體驗,AnyCharV都能提供高質量的支持。

-

靈活的輸入支持 AnyCharV不僅能夠處理傳統的圖像和視頻輸入,還能與文本到圖像(T2I)和文本到視頻(T2V)模型生成的內容相結合,展現出強大的泛化能力。

AnyCharV的技術原理:兩階段訓練策略

AnyCharV的技術優勢源于其創新的兩階段訓練策略。這一策略通過精細到粗略的引導,確保生成視頻的質量和自然度。

-

第一階段:自監督合成與細粒度引導 在第一階段,AnyCharV利用目標角色的分割掩碼和姿態信息作為條件信號,將參考角色精確地合成到目標場景中。同時,引入參考圖像的CLIP特征和ReferenceNet提取的角色外觀特征,進一步保留角色的身份和外觀。通過對分割掩碼進行強增強,AnyCharV有效減少了因形狀差異導致的細節丟失。

-

第二階段:自增強訓練與粗粒度引導 在第二階段,AnyCharV通過生成的視頻對進行自增強訓練,并用粗略的邊界框掩碼代替細分割掩碼。這種方法減少了對角色形狀的約束,使模型能夠更好地保留參考角色的細節,并在推理階段生成更自然的視頻。

AnyCharV的應用場景:多領域創新實踐

AnyCharV的泛化能力和高質量輸出使其在多個領域具有廣泛的應用潛力。以下是AnyCharV的主要應用場景:

-

影視制作 在影視特效制作中,AnyCharV能夠快速將任意角色合成到目標場景中,支持復雜的人-物交互,大幅提高特效制作的效率和質量。

-

藝術創作 AnyCharV結合文本生成內容,能夠快速生成高質量的角色視頻,激發藝術家的創意靈感,為數字藝術創作提供更多可能性。

-

虛擬現實 在虛擬現實領域,AnyCharV可以實時生成角色與虛擬場景的交互視頻,增強用戶的沉浸感,為VR應用提供更豐富的體驗。

-

廣告營銷 AnyCharV支持快速合成個性化廣告視頻,滿足廣告行業的多樣化需求,幫助企業打造更具吸引力的營銷內容。

-

教育培訓 通過生成特定角色和場景的視頻,AnyCharV能夠輔助教學和培訓,為教育行業提供更直觀、更生動的教學工具。

AnyCharV的資源鏈接:探索更多可能性

如果你對AnyCharV感興趣,可以通過以下鏈接深入了解:

-

項目官網:AnyCharV官方網站

-

GitHub倉庫:AnyCharV GitHub

-

技術論文:AnyCharV arXiv論文

結語:AnyCharV的未來展望

AnyCharV作為一款由頂尖高校聯合開發的角色可控視頻生成框架,不僅展現了AI技術的前沿水平,也為多個行業提供了創新的解決方案。無論是影視制作、藝術創作,還是虛擬現實和教育培訓,AnyCharV都展現出了巨大的應用潛力。

未來,隨著AI技術的不斷進步,AnyCharV有望在更多領域中發揮其獨特的優勢,為用戶提供更高質量的視頻生成體驗。如果你正在尋找一款靈活高效的角色視頻生成工具,不妨深入了解AnyCharV,探索它為你的項目帶來的無限可能。