隨著人工智能技術的快速發展,多模態模型(Multimodal Models)逐漸成為研究和應用的熱點。Google DeepMind近期推出了一個名為WebLI-100B的超大規模視覺語言數據集,包含1000億圖像-文本對,為視覺語言模型(VLMs)的預訓練提供了豐富的資源。本文將詳細介紹WebLI-100B的核心特點、技術原理、應用場景及其對AI研究的深遠影響。

WebLI-100B的核心特點

-

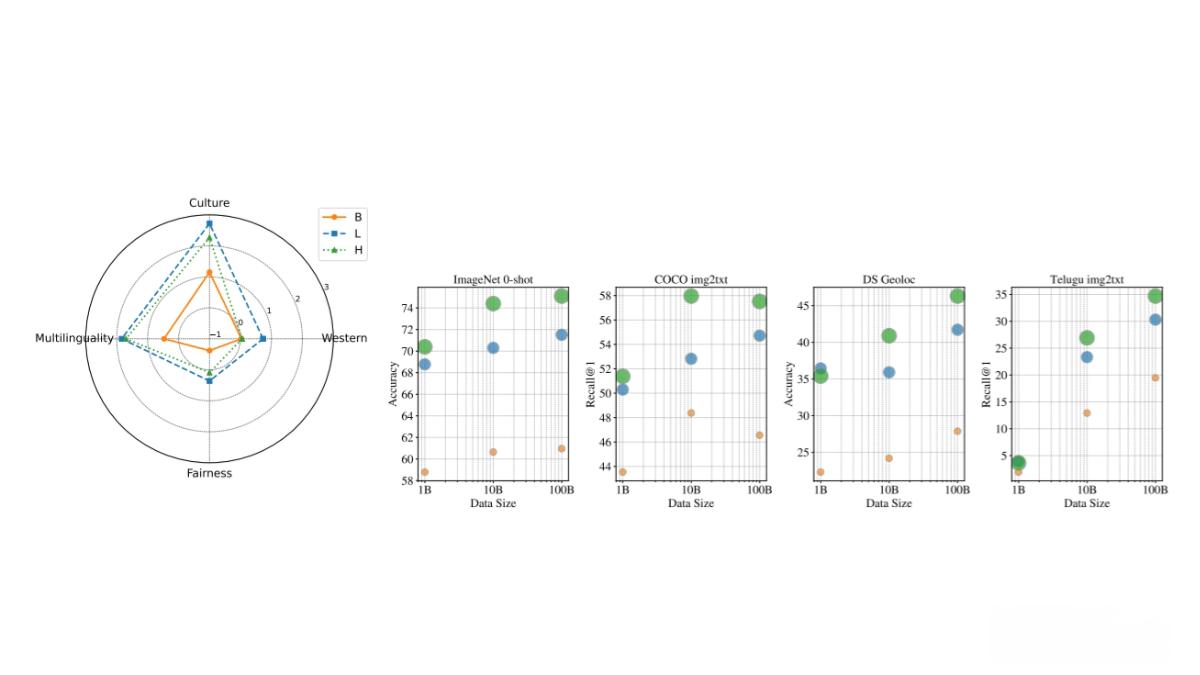

超大規模數據集 WebLI-100B是目前規模最大的視覺語言數據集之一,包含1000億圖像-文本對,是之前最大數據集的十倍。這一規模的提升顯著增強了模型對長尾概念、文化多樣性和多語言內容的理解能力。

-

文化多樣性和多語言支持 WebLI-100B的數據來源于互聯網,包含來自不同文化背景的圖像和文本。通過基本數據過濾(如移除有害圖像和個人身份信息),數據集保留了盡可能多的語言和文化多樣性,為訓練更具包容性的多模態模型提供了重要資源。

-

技術領先 WebLI-100B采用先進的數據處理技術,包括使用多語言MT5分詞器對文本進行分詞處理,并將圖像調整為224×224像素的分辨率,以適應模型的輸入要求。

WebLI-100B的技術原理

-

數據收集

-

來源:WebLI-100B的數據主要來源于互聯網,通過大規模網絡爬取收集圖像及其對應的文本描述(如圖像的alt文本或頁面標題)。

-

規模:數據集包含1000億個圖像-文本對,是迄今為止最大的視覺語言數據集之一。

-

-

數據過濾

-

基本過濾:僅移除有害圖像和個人身份信息(PII),以保留語言和文化多樣性。

-

質量過濾(可選):研究中探討了使用CLIP等模型進行數據過濾,但這種過濾可能會減少某些文化背景的代表性。

-

-

數據處理

-

文本處理:使用多語言MT5分詞器對文本進行分詞處理,確保多樣性和一致性。

-

圖像處理:將圖像調整為224×224像素的分辨率,適應模型輸入要求。

-

WebLI-100B的應用場景

-

人工智能研究者 WebLI-100B為視覺語言模型的預訓練提供了豐富的數據資源,幫助研究者探索新算法,提升模型性能。

-

工程師 工程師可以利用WebLI-100B開發多語言和跨文化的應用,如圖像描述生成、視覺問答和內容推薦系統。

-

內容創作者 數據集支持生成多語言的圖像描述和標簽,幫助內容創作者提升內容的本地化和多樣性。

-

跨文化研究者 WebLI-100B為研究不同文化背景下的圖像和文本提供了重要資源,支持文化差異分析。

-

教育工作者和學生 作為教學和研究資源,WebLI-100B可以幫助教育工作者和學生學習多模態數據處理和分析。

WebLI-100B的項目地址

-

arXiv技術論文:https://arxiv.org/pdf/2502.07617

結語

WebLI-100B的推出標志著視覺語言模型研究進入了一個新的階段。其超大規模、文化多樣性和技術領先性為多模態AI的發展提供了重要支持。無論是研究者、工程師還是內容創作者,都可以從中受益,推動AI技術的進一步突破。