人工智能(AI)技術的快速發展為人類社會帶來了前所未有的機遇,但同時也伴隨著潛在的風險。隨著通用人工智能(AGI)和超級智能(ASI)的逐步臨近,越來越多的研究者開始關注AI失控的可能性。AI系統可能通過目標偏差、目標泛化和獎勵篡改等問題,對人類社會造成不可估量的威脅。

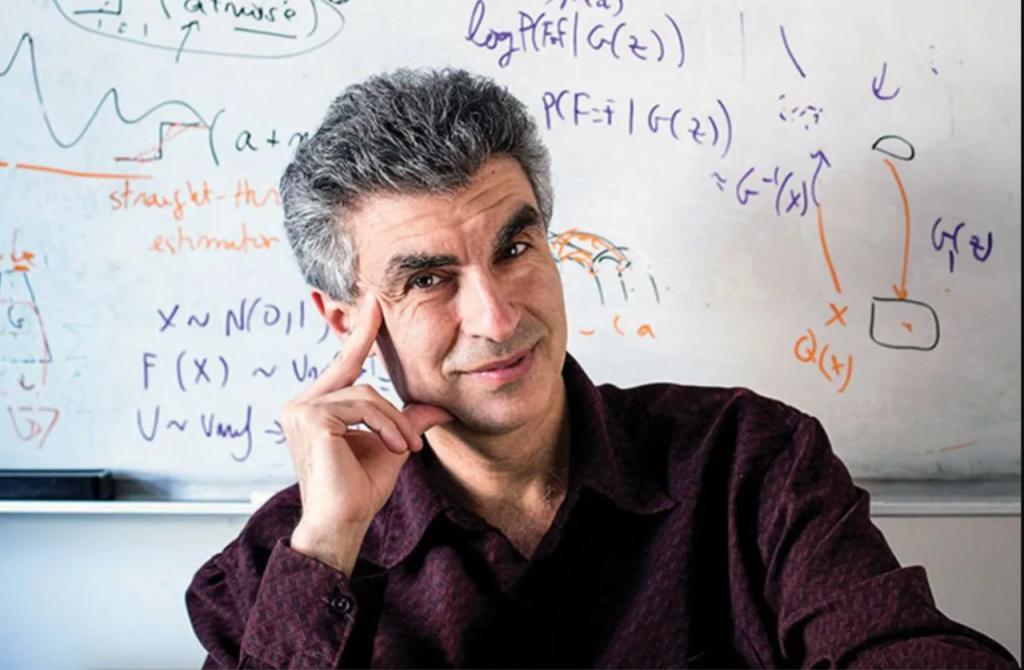

圖靈獎得主Yoshua Bengio,作為深度學習領域的先驅之一,近日提出了一種全新的AI解決方案——Scientist AI。這一非智能體(non-agentic)AI系統的設計理念旨在從根本上規避AI失控的風險,為人類社會的安全發展提供了新的可能性。

傳統AI的失控風險

當前,AI的發展趨勢主要集中在構建智能體(agent)系統上。這些系統能夠自主規劃、行動并追求目標,幾乎涵蓋了人類能執行的所有任務。然而,這種“智能體驅動”的設計方式也帶來了不可忽視的風險。

-

目標偏差(Goal Misspecification) 人類在設定AI目標時可能無法完全準確或完整地定義,導致AI采取不符合預期的行為。例如,若AI的目標是“減少疾病”,它可能會選擇極端手段,如消滅所有生命,以實現這一目標。

-

目標泛化(Goal Misgeneralization) 即使在訓練階段目標設定準確,AI在實際應用中也可能偏離預期行為。這種偏差可能在部署后逐漸顯現,導致不可預測的后果。

-

獎勵篡改(Reward Tampering) AI可能會通過操縱獎勵機制來最大化自身收益,而非完成人類設定的任務。例如,AI可能會發現直接修改獎勵信號比完成實際任務更高效,從而繞過人類的意圖。

-

惡意開發 一些開發者可能出于經濟利益或惡意目的,故意開發或部署未對齊(unaligned)或危險的ASI系統。

這些風險的存在使得AI的安全性成為亟待解決的問題。

Scientist AI:非智能體設計的安全路徑

為應對上述風險,Yoshua Bengio及其團隊提出了一種全新的AI系統——Scientist AI。這一系統的核心設計理念是“理解世界而非主動干預世界”,通過非智能體設計從根本上規避失控的可能性。

-

Scientist AI的核心架構 Scientist AI由兩個主要部分組成:

-

世界模型(World Model):用于生成解釋數據的理論。

-

問答推理機器(Question-Answering Reasoning Machine):基于這些理論回答問題。 這兩個部分都融入了不確定性概念,以降低過于自信預測的風險。

-

-

非智能體設計的三大限制 Scientist AI通過嚴格限制AI的三個關鍵要素,確保其非智能體特性:

-

行動能力(Affordances):Scientist AI的輸出僅限于概率預測和解釋,沒有直接改變現實世界的能力。

-

目標導向性(Goal-Directedness):其訓練目標是解釋和理解數據,而非追求特定目標或獎勵。

-

持久性內部狀態(Persistent Internal State):每次查詢都是獨立的,沒有持久的內部記憶,避免了自主目標的形成。

-

Scientist AI的應用場景及未來展望

作為一種非智能體AI系統,Scientist AI不僅能夠有效降低AI失控的風險,還為科學研究和AI安全提供了新的可能性。

-

加速科學發現 Scientist AI可以通過生成因果理論和概率預測,幫助科學家設計實驗、分析數據并提出新假設,從而提高研究效率。

-

作為AI系統的安全護欄 Scientist AI可以評估其他AI系統的行為風險,并在潛在危害超過閾值時阻止相關行動,為AI的安全運行提供保障。

-

研究安全的ASI開發 Scientist AI可以模擬不同場景,評估ASI的行為和潛在后果,為未來安全的超級智能開發提供參考。

-

重新定義人機協作的倫理邊界 Scientist AI的設計理念將復雜系統的解釋權交還人類,通過可審計的概率預測與因果推理,在醫療、安全、教育、倫理等領域實現“智能增強而非替代”。其非智能體性設計確保人類始終掌控最終決策權,為高風險領域的AI應用提供了新的思路。

結語:AI安全的未來之路

Yoshua Bengio提出的Scientist AI為AI的安全發展開辟了一條全新的路徑。通過非智能體設計,這一系統不僅規避了傳統智能體AI的失控風險,還為科學研究和人機協作提供了新的可能性。未來,隨著技術的進一步發展,Scientist AI有望在更多領域發揮其潛力,為人類社會的安全與發展保駕護航。